Lors de la conférence que j’ai donné au SEO Campus Paris 2019, j’ai eu l’occasion d’aborder le sujet de l’analyse de logs qui me passionne. En première partie, j’ai approfondi les facteurs qui influencent le crawl d’un site, en abordant les différents piliers du référencement naturel : contenu avec le nombre de mots, technique avec le temps de chargement, structure avec le niveau de profondeur et les liens internes et netlinking avec les liens externes.

Pour mener à bien mon analyse, j’ai mené l’expérience sur 12 sites de différentes thématiques et de différentes tailles afin d’obtenir un panel d’URLs et de site représentatifs des sites de taille petite et moyenne. En tout, j’ai ainsi rassemblé 200.000 URLs et 7.000.000 de hits de GoogletBot (ordinateur et mobile). Comme outils, j’ai utilisé Oncrawl, SEOlyzer, Log File Analyzer de Screaming Frog et SEO Tools for Excel.

Sommaire :

Contenu : Nombre de mots

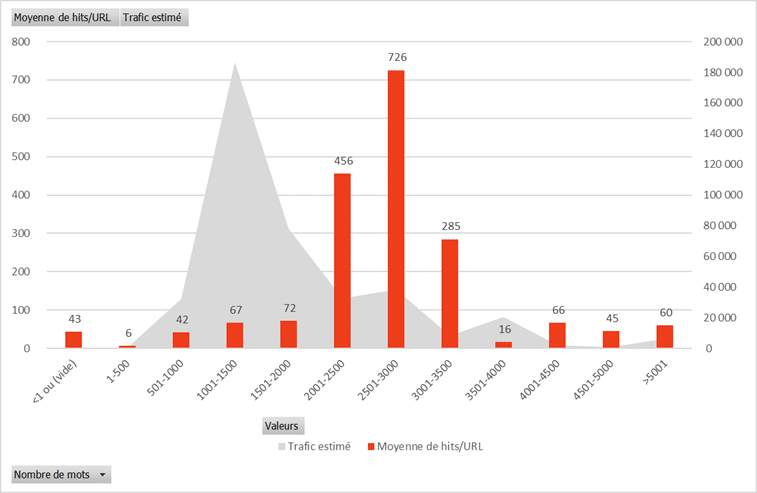

Sous forme de diagramme bâton, en orange, on retrouve la moyenne de hits par URL. L’air grisée, quant à elle, reprend le trafic estimé des URLs en question, déterminé en fonction du positionnement et de la volumétrie de recherche des mots-ckés qui positionnent l’URL.

On constate que le nombre de mots par page influe le crawl de Googlebot. En effet, les pages comprenant entre 2000 et 3500 mots sont beaucoup plus hitées que les autres, entre 285 et 726 hits en moyenne par URL. En comparaison, les autres pages sont hitées en moyenne entre 6 et 72 fois.

Au niveau des pages qui se positionnent, on observe un pic significatif de visibilité dans les résultats de recherche de Google pour les pages ayant entre 500 et 3000 mots, et tout particulièrement entre 1000 et 2000 mots.

Privilégiez les contenus de 2000 mots

Technique : Temps de chargement

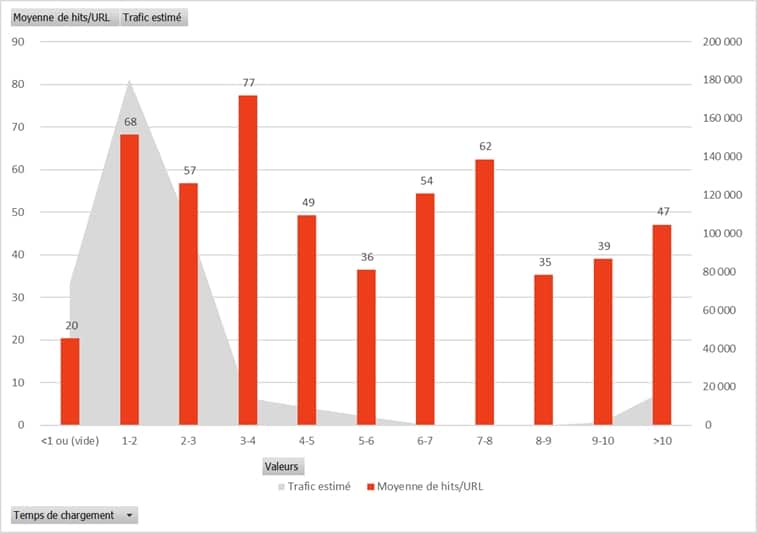

Au niveau du temps de chargement, on observe qu’il y a plus de hits sur les pages se chargeant entre 1 et 3 secondes, même si les chiffres ne sont pas aussi visibles qu’on aurait pu l’imaginer. Cela renforce la théorie selon laquelle Google crawle une URL même si elle est longue à charger, en revanche le robot crawlera un nombre moins important de pages. Il faut donc tout de même veiller à optimiser au maximum le temps de chargement.

Quant à la visibilité, on note un pic significatif sur les URLs qui se chargent en 1 seconde. Cela conforte donc l’importance du temps de chargement, sans compter que c’est également impactant pour l’expérience utilisateur.

Soignez le temps de chargement, encore plus pour les positions et l’expérience utilisateur que pour le crawl

Structure : Profondeur

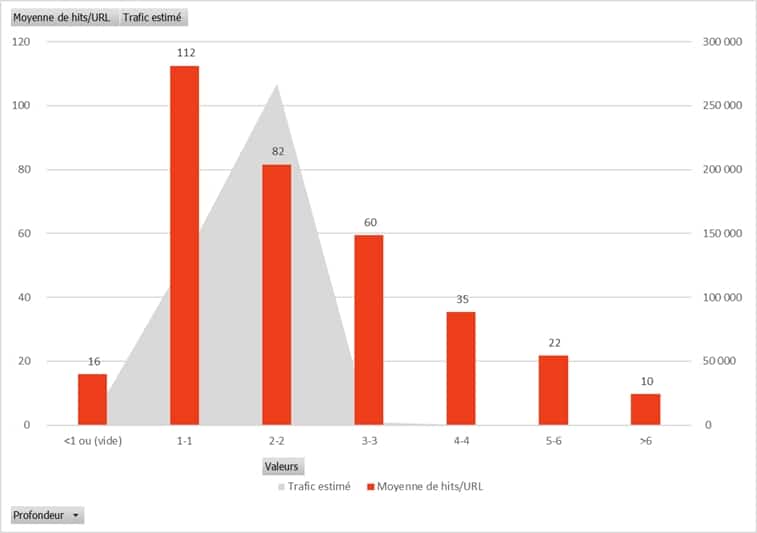

La profondeur des pages, comme on peut se l’imaginer, a en effet un impact importants sur le comportement de Googlebot et le nombre de hits moyens par URL. On constate ainsi que les pages d’accueil sont hitées 112 fois en moyenne, puis les pages qui ont une profondeur de 2 82 fois, 60 fois pour une profondeur de 3, etc… pour finir à 10 hits en moyenne par URL à un niveau de profondeur allant au-delà de 6. Les URLs qui ne sont pas dans le maillage interne, quant à elles, sont hitées seulement 16 fois en moyenne.

Au niveau du trafic organique, on observe que les pages les plus visibles sont celles ayant une profondeur de 1 et 2, avec une visibilité quasiment nulle pour les pages plus profondes.

Attention à la profondeur des pages, ne mettez pas vos pages SEO à plus de 3 clics de la home

Structure : Liens internes

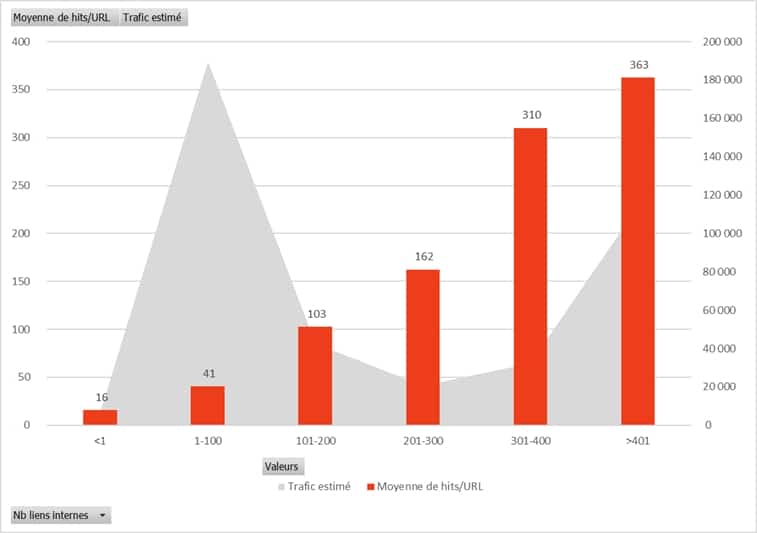

Autre paramètre influant grandement sur le crawl d’un site, il s’agit du nombre de liens internes. Ainsi, quand on observe les chiffres, on note une moyenne de hits par URL croissant en fonction de leur nombre de liens internes : plus l’URL est maillée, plus elle sera hitée, les chiffres sont réellement significatifs sur cette métrique. Dans notre panel étudié, on note ainsi une moyenne de 16 hits en moyenne par URL ne recevant aucune lien interne, contre jusqu’à 363 hits en moyenne par URL recevant plus de 400 liens internes.

En termes de trafic organique, cela n’est pas aussi visible. En effet, les URLs ayant le plus de trafic provenant des moteurs de recherche sont celles ayant entre 1 et 100 liens internes et celle ayant également plus de 400 liens internes. Ce qu’il faut en retenir, c’est qu’on retrouve en commun dans les deux dimensions les URLs les plus maillées, avec plus de 400 hits en moyenne par URL.

Maillez bien vos pages SEO dans le maillage interne

Netlinking : Liens externes

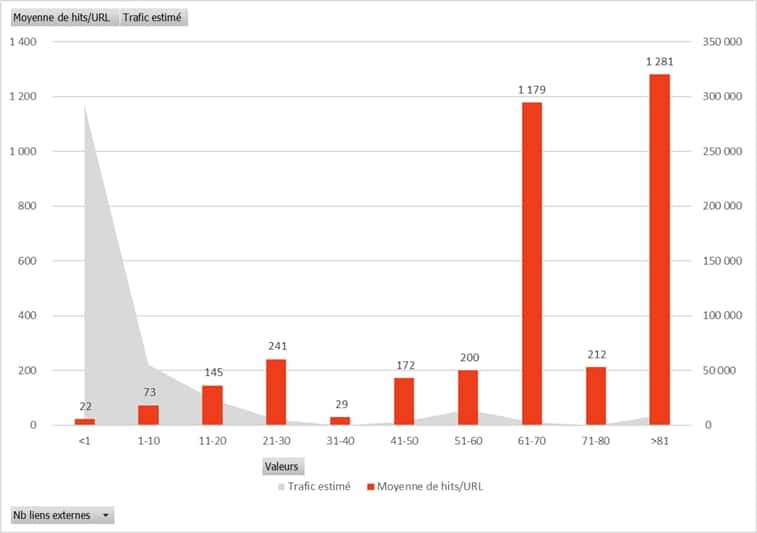

Après les liens internes, intéressons-nous aux liens externes. Les pages qui reçoivent des backlinks sont plus hitées que celles qui n’en reçoivent pas, en particulier quand le nombre de backlinks dépasse le nombre de 60. On a ainsi 22 hits en moyenne sur une page sans lien externe, contre 1179 hits sur une page recevant entre 60 et 70 liens externes. Le netlinking est donc important à prendre en compte, permettant, comme pour le maillage interne, d’augmenter la fréquence de crawl des URLs.

Une réelle stratégie de netlinking doit être mise en place pour vos pages SEO

Référencement naturel : Mot-clé top 10

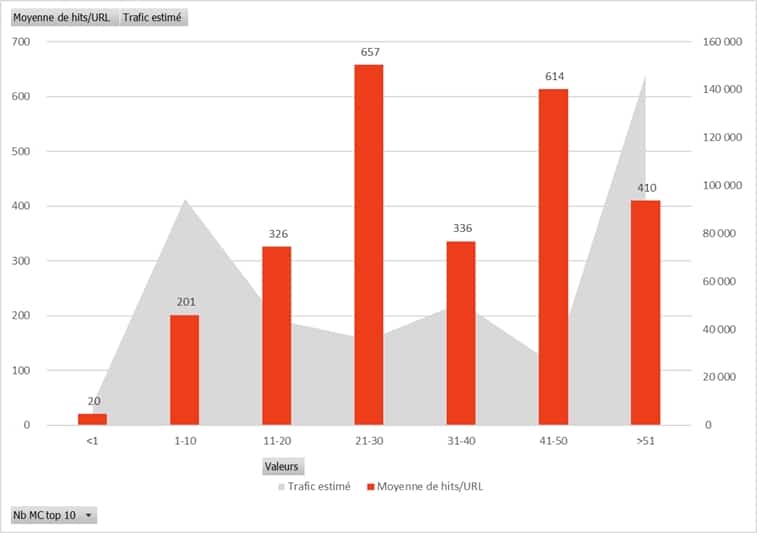

Et enfin, que se passe-t-il sur les URLs étant déjà positionnées et dont le SEO est déjà travaillé ? Et bien on observe une corrélation entre les positions dans le top 10 et la fréquence moyenne des hits de googlebot. Ainsi, tandis qu’une URL avec aucun mot-clé positionné dans le top 10 de Google sera hitée en moyenne 20 fois par les robots de google, une URL qui elle a au moins un mot-clé dans le top 10 sera hitée au moins 201 fois. Et ceci va croissant en fonction du nombre de positions dans le top 10 de Google, allant jusqu’à 410 hits en moyenne sur une URL avec plus de 50 mots-clés dans le top 10.

Ceci s’explique par le fait que Google porte encore plus d’attention aux sites bien positionnés, puisque les internautes ont beaucoup plus de chances de cliquer dessus dans les résultats de recherche, qu’un site positionné dans les pages profondes de Google. Ainsi, il vérifie régulièrement si le site est bien accessible, que le contenu des tops pages est toujours le même, etc… Cela est donc encourageant, car plus on optimise le SEO des pages internet, plus elles vont être hitées et peut-être ensuite être encore mieux positionnées… bichonnons donc nos pages SEO !

Comme la logique le veut, on a également plus de trafic organique sur les pages ayant des mots-clés positionnés dans le top 10 de Google, avec un net décrochage pour celles ayant plus de 50 mots-clés dans le top 10.

Un bon référencement naturel permettra plus de crawl de votre site par Googlebot

A retenir : Les 6 critères SEO déterminants

Dans un but d’optimiser le crawl de ses pages SEO, pour entraîner une meilleure indexation, et donc un meilleur référencement :

- Le contenu doit faire plus de 2000 mots

- La page doit se charger en 1 seconde

- Ne pas excéder un niveau de profondeur de 3

- Avoir un maximum de liens internes

- Élaborer une stratégie de netlinking (plus de 60 backlinks)

- Soigner vos pages SEO pour optimiser encore davantage leur référencement

Ceci est un cercle vertueux : plus vous optimiserez votre référencement naturel, plus votre site obtiendra de budget de crawl